Issue d’une équipe de chercheurs du CNRS et de l’INRIA, la startup française développe le hardware pour la nouvelle génération d’intelligence artificielle, l’IA probabiliste.

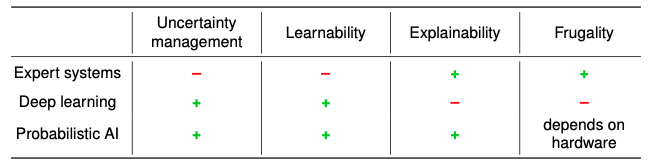

Les réseaux de neurones artificiels présentent aujourd’hui des limites. Ils demandent une (trop) grande quantité de données et consomment beaucoup de ressources pour leur exécution. L’opacité de ces réseaux complexes, dont les calculs et le raisonnement ne sont pas visibles et compréhensibles par l’homme, peut entraîner également un manque de confiance dans les résultats.

La société HawAI.Tech ouvre la voie à une nouvelle génération d’IA. Née dans le bassin grenoblois, la startup développe des accélérateurs de calcul pour l’intelligence artificielle, en s’intéressant non pas aux réseaux de neurones, mais aux modèles probabilistes, et plus particulièrement les modèles Bayésiens.

La troisième vague de l’Intelligence artificielle

Un mini-rappel historique s’impose. Trois grandes vagues structurent le développement de l’intelligence artificielle. A partir des années 1960, des systèmes experts permettent d’appliquer automatiquement des règles de raisonnement fondées sur les mathématiques. Les capacités d’apprentissage et de généralisation restent alors très limitées. A partir des années 90, les règles expertes laissent place à des algorithmes d’apprentissage automatique, s’appuyant sur de grandes quantités de données. C’est l’ère du Deep Learning et des réseaux de neurones, basés sur les modèles statistiques.

« Avec HawAI. Tech, on prépare la troisième génération d’IA, basée sur ces modèles probabilistes, en apportant une architecture de calcul optimisée pour cette IA » déclare Raphael Frisch, co-fondateur de HawAI.Tech

L’avantage de ces modèles probabilistes porte sur trois aspects, à commencer par l’explicabilité. « Avec les réseaux de neurones, on parle souvent de boîte noire. On ne sait pas ce qu’il se passe dans le modèle de l’IA, explique Raphael Frisch, co-fondateur de HawAI.Tech. Nous, on est sur une boîte ouverte, transparente pour l’utilisateur. On va pouvoir comprendre ce qu’il se passe et retracer les décisions qui ont été prises par le modèle, de manière à avoir une IA explicable. C’est quelque chose qui est fortement demandé par l’industrie aujourd’hui. Je pense au secteur du véhicule autonome, à l’aéronautique, la défense, qui sont des secteurs qui ont besoin de certifications dans de nombreux systèmes critiques ».

Les solutions d’HawAI.Tech se distinguent également par leur frugalité. D’abord, l’apprentissage du modèle nécessite une faible quantité de données. On parle non plus de Big-data, mais de Small-data.

Dans de nombreux cas pratiques, cette faible quantité de données nécessaires est un atout, notamment pour étudier les phénomènes rares. « C’est pertinent dans l’industrie pharmaceutique ou militaire. Par exemple si je veux faire un simulateur de missile, je ne vais pas faire exploser un missile à chaque fois pour faire un data-point » illustre le CEO.

Plutôt que de s’appuyer sur une quantité astronomique de données, les modèles probabilistes vont directement incorporer un savoir expert.

« Vous avez une machine que vous utilisez depuis des années et vous voulez faire de la maintenance prédictive, pose Raphael Frisch. Avec les réseaux de neurones, vous allez devoir mettre des capteurs, faire tourner la machine pendant quelques semaines ou mois pour récolter les données de training et apprendre les paramètres de votre réseau de neurones. Nous, on va s’asseoir avec la personne qui, depuis des années, s’occupe de la maintenance de cette machine. Elle connaît son fonctionnement, ses réactions. On va modéliser son savoir expert au sein du modèle, qui permettra au modèle probabiliste d’être exécuté ».

La frugalité s’illustre également dans les ressources énergétiques nécessaires. « Certains grands modèles d’IA de réseaux de neurones consomment énormément d’énergie. Des millions de dollars sont dépensés juste pour l’apprentissage de ces modèles, rappelle Raphael Frisch. À l’inverse, notre IA demande beaucoup moins de ressources pour son exécution ».

La troisième caractéristique des modèles probabilistes consiste en la gestion de l’incertitude. Le degré de précision des données récoltées par les capteurs, l’incertitude sur les observations et décisions prises, doivent être prises en compte dans le modèle. « On modélise cette incertitude de manière intrinsèque, puisqu’on est basé sur les probabilités. Or, une probabilité, c’est une incertitude, un indicateur de confiance par rapport à une information (un output) ».

Industrie 4.0

Les champs d’application des accélérateurs de calcul produits par HawAI.Tech est vaste. « Ils sont destinés au secteur de l’Edge Computing pour du calcul local, embarqué, proche du capteur » précise Raphael Frisch. L’industrie de l’aéronautique, le monde de la défense, l’industrie 4.0, avec la maintenance prédictive et le contrôle de procédé, sont des cibles prioritaires pour l’entreprise française.

« On travaille par exemple sur la maintenance prédictive dans des centres de logistique, avec des problématiques de maintenance sur les machines et la prédiction des pannes. » cite le CEO.

La conception et la production de ces accélérateurs de calcul innovants sont le fruit de longues années de recherche. « On a un fort historique académique dans l’équipe. On est une dizaine de personnes, rencontrées au fil de différents projets de recherche au CNRS et à l’INRIA. » précise Raphael Frisch.

Cette expertise académique se double d’un fort engouement pour l’entrepreneuriat. « On a cette volonté de rendre cette recherche plus mature et l’emmener sur le marché, pour répondre à des problématiques plus concrètes dans le monde de l’entreprise ».

La société s’entoure d’ailleurs de partenaires pour s’implanter dans le réseau d’acteurs de l’IA probabiliste, familiariser les utilisateurs avec le hardware et s’ouvrir de nouveaux marchés. « On est en train de constituer une équipe pour justement accompagner nos utilisateurs, être proche du marché et comprendre les besoins, informe Raphael Frisch. C’est dans ce contexte-là qu’on rejoint le programme HPE. On veut trouver des cas d’usage chez eux, chez leurs partenaires, et répondre aux problématiques d’Edge Computing avec l’IA probabiliste ».

Cartes sur tables en 2023

En pleine expansion commerciale, HawAI.Tech bâtit progressivement son équipe marketing et communication, avant l’arrivée d’une première solution commercialisable en 2023. « Ce sont des cartes configurables qu’on va programmer et qui vont se comporter de la même manière que notre puce, appelées FPGA. On vise des gains en efficacité énergétique 40 fois supérieur à une carte graphique classique, avec 20 fois plus de rapidité, tout en consommant deux fois moins d’énergie » détaille le CEO.

Une puce propre à HawAI. Tech, l’ASIC, est prévue pour 2026, avec cette fois une efficacité énergétique 500 fois supérieur à un GPU, cinquante fois plus rapide, et dix fois moins consommatrice.

« Ce qui a permis aux réseaux de neurones de décoller, c’est les GPU. Nous, on prépare le hardware pour cette 3e génération d’intelligence artificielle, compare Raphael Frisch. On a comme vocation à devenir le leader des calculateurs pour l’IA probabiliste ».